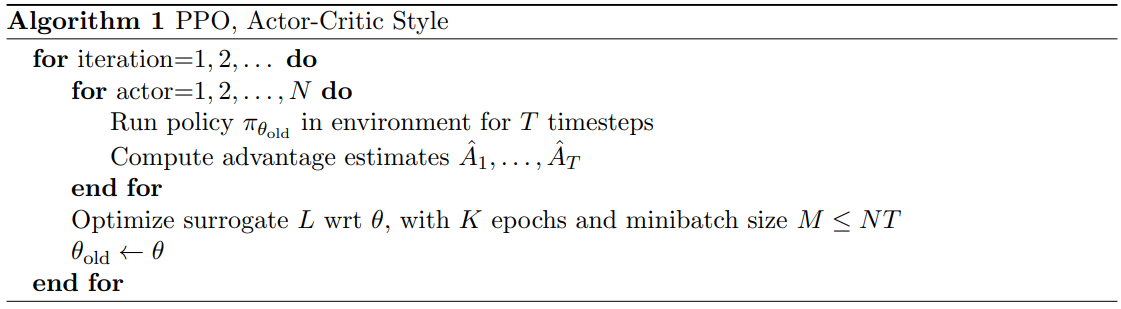

2022.01.18 - [ReinforcementLearning] - TRPO와 PRO 구현 - 연속행동으로 에이전트를 제어하기 위해 폴리시 그래디언트 알고리즘을 로보스쿨이라는 환경이 적용 - 쉬운 구현과 상징성의 이유로 아직까지 제일 유명한 알고리즘. - first-order optimization 만을 이용해 구현이 매우 쉬우며, TRPO만큼의 성능을 지니면서 data effciency 문제와 TRPO의 복잡하고,noise를 포함한 구조의 문제점들을 해결하였다. PPO의 주요 장점은 무엇인가? PPO는 TRPO와 유사하지만 1차 최적화 메서드만 사용해 목적함수를 최적화 한다. PPO는 목표함수가 너무 커지면 목적함수를 정리 Clipping해 폴리시가 너무 큰 스텝을 취하지 않게 한다. PPO가 좋은 ..